NVIDIA ha deciso di rendere open source Audio2Face, una delle tecnologie di intelligenza artificiale più interessanti del suo catalogo. L'azienda statunitense raramente apre il codice delle proprie soluzioni, preferendo modelli chiusi e proprietari, e ora sviluppatori, ricercatori e studenti avranno libero accesso a un sistema che permette di generare animazioni facciali in tempo reale a partire da tracce audio.

La licenza scelta è la MIT, una delle più permissive, che consente l'uso e la modifica del codice per progetti personali e commerciali. L'obiettivo dichiarato è incoraggiare un utilizzo più ampio della tecnologia, anche al di fuori degli ambiti tradizionali, favorendo così l'espansione di nuove applicazioni basate sull'IA. Comprende poi non solo i modelli già pronti, ma anche l'SDK, gli strumenti di addestramento e dataset di esempio.

Come funziona Audio2Face

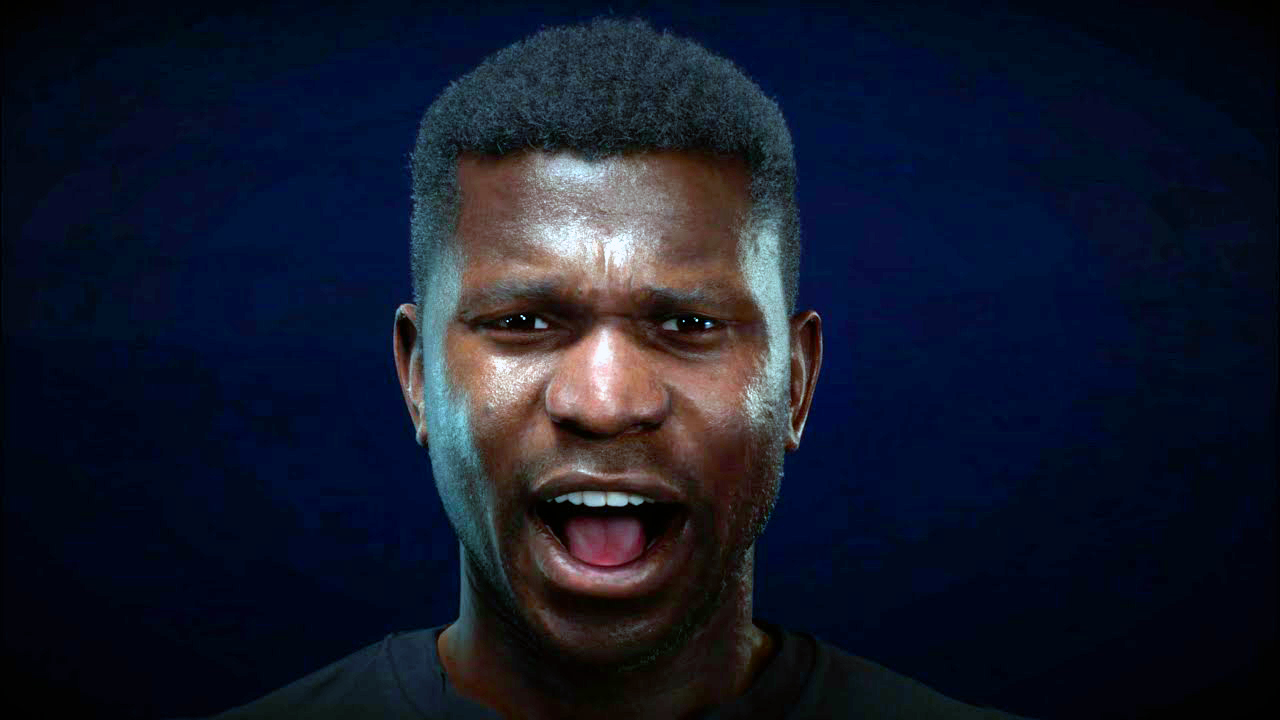

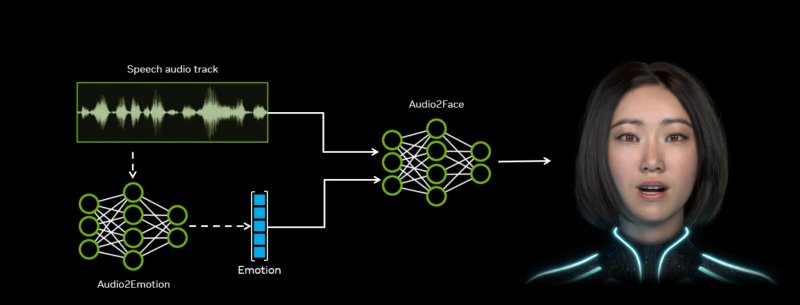

Audio2Face utilizza l'audio come sorgente principale per generare in tempo reale animazioni del volto e sincronizzazione labiale. Analizza fonemi, intonazione e tono emotivo del parlato, trasformando queste informazioni in dati che possono essere applicati a modelli 3D. Il risultato è una resa più naturale e credibile dei personaggi digitali.

Il sistema è compatibile con strumenti professionali molto diffusi come Autodesk Maya e Unreal Engine 5, grazie a plugin dedicati. In questo modo, i creativi possono integrare Audio2Face direttamente nei flussi di lavoro già esistenti, riducendo tempi e costi di produzione rispetto alle tecniche tradizionali di motion capture.

NVIDIA ha messo a disposizione diverse tipologie di modelli. Sono inclusi quelli basati su regressione e diffusione per la sincronizzazione labiale, oltre alle reti Audio2Emotion, che permettono di riconoscere lo stato emotivo a partire dalla voce. Questo consente di arricchire ulteriormente le animazioni, rendendo i personaggi non solo sincronizzati nel parlato, ma anche espressivi dal punto di vista emotivo.

Gli sviluppatori possono utilizzare i modelli così come sono oppure affinarli e riaddestrarli in base alle esigenze dei propri progetti. Grazie all'apertura anche del framework di training, è possibile adattare Audio2Face a contesti che vanno oltre l'animazione tradizionale.

Audio2Face è già stato sperimentato in ambito commerciale. Lo studio The Farm 51 lo ha impiegato per Chernobylite 2: Exclusion Zone, ottenendo un'accelerazione significativa nei processi di animazione e una resa più realistica dei personaggi. Altri partner che hanno adottato o testato la tecnologia includono Codemasters, GSC Game World, NetEase, Perfect World, Convai, Inworld AI, Reallusion, Streamlabs e UneeQ.

Il principale vantaggio rispetto al performance capture tradizionale è la possibilità di ottenere risultati credibili senza dover ricorrere a infrastrutture costose o lunghe sessioni di registrazione. Per gli studi di sviluppo, significa pipeline più snelle e maggiore rapidità nella realizzazione di contenuti. Il tutto mentre OpenAI e NVIDIA hanno da poco siglato un super accordo da 100 miliardi di dollari per l'IA.