Per anni il dibattito sull'hardware per l'intelligenza artificiale si è concentrato quasi esclusivamente su GPU e memoria ad altissima banda. Non a caso, la crescita di SK hynix è stata trainata proprio dall'esplosione delle memorie HBM, diventata una componente imprescindibile per acceleratori IA come quelli di NVIDIA. Ma oggi lo scenario sta cambiando in modo netto, spinto da un passaggio fondamentale: l'AI non è più solo addestramento, è soprattutto inferenza.

Quando la memoria HBM non basta più

L'inferenza è la fase in cui i modelli vengono realmente utilizzati, rispondendo alle richieste degli utenti, mantenendo contesto, personalizzazione e continuità. Ed è proprio qui che la memoria HBM inizia a mostrare i suoi limiti strutturali. La capacità disponibile per singola GPU resta relativamente ridotta, i costi sono elevati e la natura volatile di questa memoria la rende poco adatta a conservare grandi quantità di dati persistenti. Il risultato è un'infrastruttura sempre più complessa, costosa e difficile da scalare.

È in questo contesto che nasce la collaborazione formale tra SK hynix e NVIDIA sul fronte degli SSD di nuova generazione. L'obiettivo non è semplicemente migliorare prodotti esistenti, ma ripensare il ruolo dello storage all'interno delle architetture IA, trasformandolo da componente passiva a elemento attivo delle prestazioni complessive.

Secondo quanto emerso dal settore, le due aziende stanno lavorando a soluzioni di storage progettate specificamente per i carichi di lavoro dell'inferenza IA. Parliamo di SSD capaci di gestire volumi di dati enormi con latenze estremamente ridotte, riducendo la distanza tra memoria, storage e calcolo. L'ambizione è chiara: avvicinare lo storage alle prestazioni tipicamente associate alla memoria, senza rinunciare ai vantaggi della non volatilità.

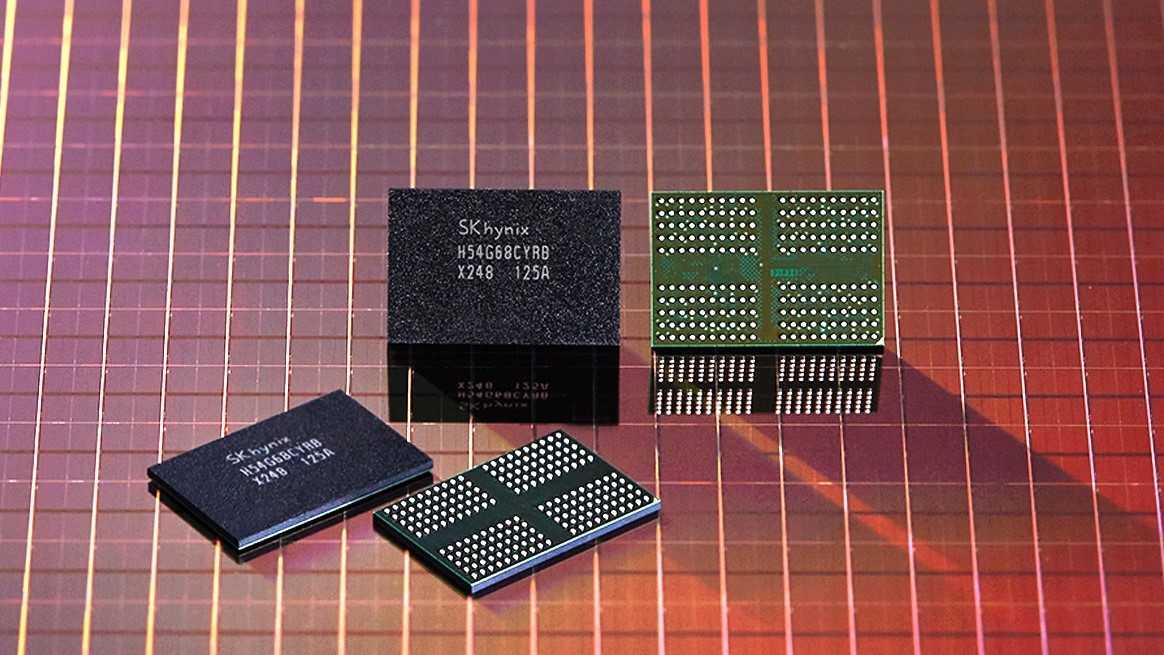

La NAND diventa un elemento strategico per l’IA

Questo approccio riflette una consapevolezza ormai diffusa tra i grandi player tecnologici. I modelli di intelligenza artificiale di ultima generazione richiedono quantità di dati che superano ampiamente ciò che può essere mantenuto esclusivamente in HBM. L'inferenza su modelli avanzati, soprattutto quando personalizzata sull'utente, necessita di accedere rapidamente a contesti molto ampi, storici di interazione e informazioni persistenti. In altre parole, serve una memoria che non dimentichi e che sia comunque veloce.

Ciò che rende questa fase particolarmente interessante è il metodo. A differenza del passato, non si parla più di memorie generaliste adattate a posteriori dai clienti. L'IA sta imponendo un modello di sviluppo su misura, in cui produttori di chip e fornitori di piattaforme collaborano fin dalle prime fasi per costruire soluzioni cucite su specifici casi d'uso. È un cambio di paradigma che ridisegna i rapporti di forza lungo tutta la filiera dei semiconduttori.